Recherche en Psychologie

I

P01 : Laboratoire de perception et d’attention

Sevda Montakhaby Nodeh

Laboratoire de perception et d’attention

En tant que chercheur en sciences cognitives au Cognition and Attention Lab de l’Université McMaster, vous êtes à la pointe de l’exploration des subtilités du contrôle proactif dans les processus d’attention. Cette ligne de recherche est d’une grande importance, étant donné que le système sensoriel humain est submergé par une vaste gamme d’informations à chaque seconde, dépassant ce qui peut être traité de manière significative. L’essence de la recherche sur l’attention consiste à décrypter les mécanismes par lesquels l’entrée sensorielle est parcourue et gérée de manière sélective. Cela est particulièrement important pour comprendre comment les individus anticipent et s’adaptent en vue de tâches ou de stimuli à venir, un phénomène particulièrement pertinent dans des environnements regorgeant de distractions potentielles.

Dans la vie de tous les jours, les conflits attentionnels sont monnaie courante et se manifestent lorsque des informations non pertinentes par rapport à un objectif entrent en compétition avec des données pertinentes par rapport à un objectif pour la priorité attentionnelle. Un exemple de ce phénomène (que nous ne connaissons que trop bien, j’en suis sûr) est la perturbation causée par les notifications sur nos appareils mobiles, qui peuvent nous détourner de nos objectifs principaux, tels que les études ou la conduite. D’un point de vue scientifique, l’élucidation des stratégies employées par le système cognitif humain pour optimiser la sélection et le maintien d’un comportement orienté vers un objectif représente un défi formidable et irrésistible.

Votre recherche en cours est une réponse directe à ce défi. Elle examine comment le contrôle proactif influence la capacité à se concentrer sur les informations pertinentes pour la tâche tout en écartant efficacement les distractions. Cette facette de la fonctionnalité cognitive n’est pas seulement une construction théorique ; c’est le fondement même du comportement et de l’interaction humaine au quotidien.

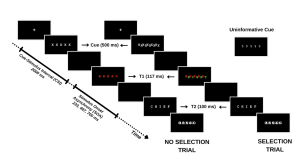

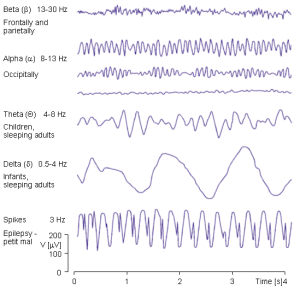

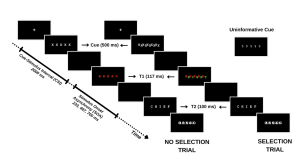

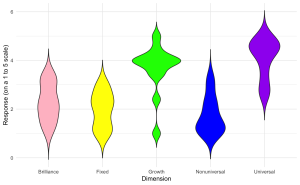

Votre étude évalue méthodiquement cette dynamique en engageant les participants dans une tâche où ils doivent identifier une séquence de mots dans des conditions variables. Le premier mot (T1) est présenté en rouge, suivi rapidement par un second mot (T2) en blanc. L’intervalle entre l’apparition de T1 et T2, connu sous le nom d’asynchronisme d’apparition du stimulus (SOA), sert de mesure critique dans votre expérience. La particularité de votre étude réside dans la façon dont vous manipulez les demandes d’attention sélective dans chaque essai, classées comme suit :

- Essais sans sélection : T1 apparaît seul, ce qui conduit généralement à une précision d’identification supérieure pour T1 et T2 en raison d’une charge cognitive réduite.

- Essais de sélection : T1 est entrecoupée d’un mot distracteur vert. Dans ces essais plus exigeants, le distracteur vert est en concurrence avec le mot cible rouge, ce qui entraîne une baisse de la précision d’identification pour T1 et T2.

En introduisant des indices informatifs et non informatifs, votre enquête sonde le rôle du contrôle proactif. Les indices informatifs donnent aux participants un aperçu du type d’épreuve à venir, ce qui leur permet de se préparer mentalement au défi imminent. À l’inverse, les indices non informatifs agissent comme des essais de contrôle et n’offrent aucune indication sur le type d’essai. L’hypothèse est que ces indices informatifs permettent aux participants d’ajuster leur attention de manière proactive en prévision d’un conflit attentionnel, ce qui pourrait améliorer les performances lors des essais de sélection avec des indices informatifs par rapport à ceux avec des indices non informatifs.

Pour une vue d’ensemble des différents types d’essais, veuillez vous référer à la figure ci-dessous. (le texte de la figure demeure toutefois en anglais seulement)

Dans le cadre de cette étude, vous vous attaquez non seulement à la question plus générale du rôle de l’effort conscient dans l’attention, mais vous contribuez également à une compréhension nuancée des processus cognitifs humains, ouvrant la voie à des applications qui vont de l’amélioration de la productivité de la vie quotidienne à l’optimisation des interfaces technologiques en vue d’une perturbation minimale de la cognition.

Mise en route : Chargement des progiciels , définition du répertoire de travail et chargement du jeu de données

Commençons par exécuter le code suivant dans RStudio pour charger les bibliothèques requises. Veillez à lire les commentaires intégrés dans le code pour comprendre ce que fait chaque ligne de code.

Remarque : les cases grisées contiennent le code R, le signe “#” indiquant un commentaire qui ne s’exécutera pas dans RStudio.

# Here we create a list called "my_packages" with all of our required libraries

my_packages <- c("tidyverse", "rstatix", "readxl", "xlsx", "emmeans", "afex",

"kableExtra", "grid", "gridExtra", "superb", "ggpubr", "lsmeans")

# Checking and extracting packages that are not already installed

not_installed <- my_packages[!(my_packages %in% installed.packages()[ , "Package"])]

# Install packages that are not already installed

if(length(not_installed)) install.packages(not_installed)

# Loading the required libraries

library(tidyverse) # for data manipulation

library(rstatix) # for statistical analyses

library(readxl) # to read excel files

library(xlsx) # to create excel files

library(kableExtra) # formatting html ANOVA tables

library(superb) # production of summary stat with adjusted error bars(Cousineau, Goulet, & Harding, 2021)

library(ggpubr) # for making plots

library(grid) # for plots

library(gridExtra) # for arranging multiple ggplots for extraction

library(lsmeans) # for pairwise comparisons

Assurez-vous d’avoir téléchargé l’ensemble de données requis (“ProactiveControlCueing.xlsx”) pour cet exercice. Définissez le répertoire de travail de votre session R actuelle dans le dossier contenant l’ensemble de données téléchargé. Vous pouvez le faire manuellement dans le studio R en cliquant sur l’onglet “Session” en haut de l’écran, puis en cliquant sur “Set Working Directory”.

Si le fichier de données téléchargé et votre session R se trouvent dans le même dossier, vous pouvez choisir de définir votre répertoire de travail sur “l’emplacement du fichier source” (l’emplacement où votre session R actuelle est sauvegardée). S’ils se trouvent dans des dossiers différents, cliquez sur l’option “choisir un répertoire” et recherchez l’emplacement du jeu de données téléchargé.

Vous pouvez également effectuer cette opération en exécutant le code suivant

Une fois que vous avez défini votre répertoire de travail, manuellement ou par code, la console ci-dessous affiche le répertoire complet de votre dossier.

Lisez l’ensemble de données téléchargé sous le nom de “cueingData” et effectuez les exercices qui l’accompagnent au mieux de vos capacités.

# Read xlsx file

cueingData = read_excel("ProactiveControlCueing.xlsx")

Fichiers à télécharger :

- ProactiveControlCueing.xlsx

An interactive H5P element has been excluded from this version of the text. You can view it online here:

https://ecampusontario.pressbooks.pub/rspnc/?p=144#h5p-1

Solutions

Exercice 1 – Préparation et exploration des données

Après avoir configuré les progiciels nécessaires, établi votre répertoire de travail et chargé l’ensemble de données (“cueingData”) dans RStudio, procédez aux exercices ci-dessous. Copiez et collez votre code R dans les zones de texte prévues à cet effet. Vous pouvez exporter les exercices et vos réponses à la fin de cet exercice en tant que fichier docx à partir de la page d’exportation de documents une fois que vous avez terminé.

Une fois les exercices terminés, comparez vos solutions au corrigé inclus ci-dessous. N’oubliez pas que RStudio peut produire des résultats identiques par le biais de différentes méthodes. Ne vous découragez donc pas si votre code diffère du corrigé, à condition que vos résultats soient corrects.

- Affichez les premières rangées de vos données

head(cueingData) #Displaying the first few rows

## # A tibble: 6 × 6

## ID CUE_TYPE TRIAL_TYPE SOA T1Score T2Score

## <dbl> <chr> <chr> <dbl> <dbl> <dbl>

## 1 1 INFORMATIVE NS 233 100 94.6

## 2 2 INFORMATIVE NS 233 100 97.2

## 3 3 INFORMATIVE NS 233 89.2 93.9

## 4 4 INFORMATIVE NS 233 100 91.9

## 5 5 INFORMATIVE NS 233 100 100

## 6 6 INFORMATIVE NS 233 100 97.3

2. Définissez vos facteurs et vérifiez leur structure. Assurez-vous que vos mesures dépendantes sont sous forme numérique et que vos facteurs et niveaux sont correctement configurés.

cueingData <- cueingData %>%

convert_as_factor(ID, CUE_TYPE, TRIAL_TYPE, SOA) #setting up factors

str(cueingData) #checking that factors and levels are set-up correctly. Checking to see that dependent measures are in numerical format.

## # A tibble: 6 × 6

## ID CUE_TYPE TRIAL_TYPE SOA T1Score T2Score

## <dbl> <chr> <chr> <dbl> <dbl> <dbl>

## 1 1 INFORMATIVE NS 233 100 94.6

## 2 2 INFORMATIVE NS 233 100 97.2

## 3 3 INFORMATIVE NS 233 89.2 93.9

## 4 4 INFORMATIVE NS 233 100 91.9

## 5 5 INFORMATIVE NS 233 100 100

## 6 6 INFORMATIVE NS 233 100 97.3

## tibble [192 × 6] (S3: tbl_df/tbl/data.frame)

## $ ID : Factor w/ 16 levels "1","2","3","4",..: 1 2 3 4 5 6 7 8 9 10 ...

## $ CUE_TYPE : Factor w/ 2 levels "INFORMATIVE",..: 1 1 1 1 1 1 1 1 1 1 ...

## $ TRIAL_TYPE: Factor w/ 2 levels "NS","S": 1 1 1 1 1 1 1 1 1 1 ...

## $ SOA : Factor w/ 3 levels "233","467","700": 1 1 1 1 1 1 1 1 1 1 ...

## $ T1Score : num [1:192] 100 100 89.2 100 100 ...

## $ T2Score : num [1:192] 94.6 97.2 93.9 91.9 100 ...

3. Effectuer des contrôles de base des données pour vérifier les valeurs manquantes et la cohérence des données

sum(is.na(cueingData)) # Checking for missing values in the dataset

summary(cueingData) # Viewing the summary of the dataset to check for inconsistencies

## ID CUE_TYPE TRIAL_TYPE SOA T1Score

## 1 : 12 INFORMATIVE :96 NS:96 233:64 Min. : 32.43

## 2 : 12 UNINFORMATIVE:96 S :96 467:64 1st Qu.: 77.78

## 3 : 12 700:64 Median : 95.87

## 4 : 12 Mean : 86.33

## 5 : 12 3rd Qu.:100.00

## 6 : 12 Max. :100.00

## (Other):120

## T2Score

## Min. : 29.63

## 1st Qu.: 83.97

## Median : 95.76

## Mean : 87.84

## 3rd Qu.:100.00

## Max. :100.00

- Vos données correspondent-elles à un plan équilibré ou déséquilibré ? (Conseil : utilisez un code pour indiquer le nombre d’observations par combinaison de facteurs)

table(cueingData$CUE_TYPE, cueingData$TRIAL_TYPE, cueingData$SOA) #checking the number of observations per condition or combination of factors. Data is a balanced design since there is an equal number of observations per cell.

## , , = 233

##

##

## NS S

## INFORMATIVE 16 16

## UNINFORMATIVE 16 16

##

## , , = 467

##

##

## NS S

## INFORMATIVE 16 16

## UNINFORMATIVE 16 16

##

## , , = 700

##

##

## NS S

## INFORMATIVE 16 16

## UNINFORMATIVE 16 16

Exercice 2 – Calculer les statistiques sommaires

Nous utiliserons ici la bibliothèque Superb pour calculer nos statistiques sommaires avec l’erreur standard des mesures moyennes qui ont été corrigées pour les comparaisons entre sujets.

Pour vous familiariser avec la bibliothèque Superb, je vous suggère de lire l’article publié suivant et de regarder les tutoriels YouTube.

Cousineau D, Goulet M, Harding B (2021). “Graphiques sommaires avec barres d’erreur ajustées : The superb framework with an implementation in R.” Advances in Methods and Practices in Psychological Science, 2021, 1-46. doi : https://doi.org/10.1177/25152459211035109

Walker, J. A. L. (2021). “Summary plots with adjusted error bars (superb)”. Vidéo Youtube, accessible ici.

Walker, J. A. L. (2021). Summary plots with adjusted error bars (superb). Extrait de https://www.youtube.com/watch?v=rw_6ll5nVus

Pour jouer avec les différentes fonctionnalités de la bibliothèque superb, une application Shiny avec une vue de constructeur pour la bibliothèque est également disponible sur le web. Vous trouverez également ci-dessous une ressource utile pour naviguer dans le code R de la bibliothèque Superb.

5. La bibliothèque Superb exige que votre jeu de données soit dans un format large. Convertissez donc votre jeu de données d’un format long à un format large. Enregistrez-le sous “cueingData.wide”.

cueingData.wide <- cueingData %>%

pivot_wider(names_from = c(TRIAL_TYPE, SOA, CUE_TYPE),

values_from = c(T1Score, T2Score) )

6. En utilisant superbPlot() et cueingData.wide, calculez la moyenne et l’erreur standard de la moyenne (SEM) pour les scores T1 et T2 à chaque niveau des facteurs. Veillez à calculer les valeurs SEM corrigées de Cousineau-Morey.

- Vous devez le faire séparément pour chacune de vos mesures dépendantes. Enregistrez votre fonction superbplot pour T1Score sous “EXP1.T1.plot” et sous “EXP1.T2.plot” pour T2Score.

- Renommez les niveaux des facteurs dans chaque graphique. Actuellement, les niveaux sont numérotés. Nous voulons que les niveaux de SOA soient 233, 467 et 700 ; que les niveaux de type de repère soient Informatif et Non informatif, et que les niveaux de type d’essai soient Sélection et Pas de sélection (Astuce : pour accéder aux données récapitulatives, utilisez EXP1.T1.plot$data$insertfactorname).

EXP1.T1.plot <- superbPlot(cueingData.wide,

WSFactors = c("SOA(3)", "CueType(2)", "TrialType(2)"),

variables = c("T1Score_NS_233_INFORMATIVE", "T1Score_NS_467_INFORMATIVE",

"T1Score_NS_700_INFORMATIVE", "T1Score_NS_233_UNINFORMATIVE",

"T1Score_NS_467_UNINFORMATIVE", "T1Score_NS_700_UNINFORMATIVE",

"T1Score_S_233_INFORMATIVE", "T1Score_S_467_INFORMATIVE",

"T1Score_S_700_INFORMATIVE", "T1Score_S_233_UNINFORMATIVE",

"T1Score_S_467_UNINFORMATIVE", "T1Score_S_700_UNINFORMATIVE"),

statistic = "mean",

errorbar = "SE",

adjustments = list(

purpose = "difference",

decorrelation = "CM",

popSize = 32

),

plotStyle = "line",

factorOrder = c("SOA", "CueType", "TrialType"),

lineParams = list(size=1, linetype="dashed"),

pointParams = list(size = 3))

## superb::FYI: Here is how the within-subject variables are understood:

## SOA CueType TrialType variable

## 1 1 1 T1Score_NS_233_INFORMATIVE

## 2 1 1 T1Score_NS_467_INFORMATIVE

## 3 1 1 T1Score_NS_700_INFORMATIVE

## 1 2 1 T1Score_NS_233_UNINFORMATIVE

## 2 2 1 T1Score_NS_467_UNINFORMATIVE

## 3 2 1 T1Score_NS_700_UNINFORMATIVE

## 1 1 2 T1Score_S_233_INFORMATIVE

## 2 1 2 T1Score_S_467_INFORMATIVE

## 3 1 2 T1Score_S_700_INFORMATIVE

## 1 2 2 T1Score_S_233_UNINFORMATIVE

## 2 2 2 T1Score_S_467_UNINFORMATIVE

## 3 2 2 T1Score_S_700_UNINFORMATIVE

## superb::FYI: The HyunhFeldtEpsilon measure of sphericity per group are 0.134

## superb::FYI: Some of the groups' data are not spherical. Use error bars with caution.

EXP1.T2.plot <- superbPlot(cueingData.wide,

WSFactors = c("SOA(3)", "CueType(2)", "TrialType(2)"),

variables = c("T2Score_NS_233_INFORMATIVE", "T2Score_NS_467_INFORMATIVE",

"T2Score_NS_700_INFORMATIVE", "T2Score_NS_233_UNINFORMATIVE",

"T2Score_NS_467_UNINFORMATIVE", "T2Score_NS_700_UNINFORMATIVE",

"T2Score_S_233_INFORMATIVE", "T2Score_S_467_INFORMATIVE",

"T2Score_S_700_INFORMATIVE", "T2Score_S_233_UNINFORMATIVE",

"T2Score_S_467_UNINFORMATIVE", "T2Score_S_700_UNINFORMATIVE"),

statistic = "mean",

errorbar = "SE",

adjustments = list(

purpose = "difference",

decorrelation = "CM",

popSize = 32

),

plotStyle = "line",

factorOrder = c("SOA", "CueType", "TrialType"),

lineParams = list(size=1, linetype="dashed"),

pointParams = list(size = 3)

)

## superb::FYI: Here is how the within-subject variables are understood:

## SOA CueType TrialType variable

## 1 1 1 T2Score_NS_233_INFORMATIVE

## 2 1 1 T2Score_NS_467_INFORMATIVE

## 3 1 1 T2Score_NS_700_INFORMATIVE

## 1 2 1 T2Score_NS_233_UNINFORMATIVE

## 2 2 1 T2Score_NS_467_UNINFORMATIVE

## 3 2 1 T2Score_NS_700_UNINFORMATIVE

## 1 1 2 T2Score_S_233_INFORMATIVE

## 2 1 2 T2Score_S_467_INFORMATIVE

## 3 1 2 T2Score_S_700_INFORMATIVE

## 1 2 2 T2Score_S_233_UNINFORMATIVE

## 2 2 2 T2Score_S_467_UNINFORMATIVE

## 3 2 2 T2Score_S_700_UNINFORMATIVE

## superb::FYI: The HyunhFeldtEpsilon measure of sphericity per group are 0.226

## superb::FYI: Some of the groups' data are not spherical. Use error bars with caution.

# Re-naming levels of the factors

levels(EXP1.T1.plot$data$SOA) <- c("1" = "233", "2" = "467", "3" = "700")

levels(EXP1.T2.plot$data$SOA) <- c("1" = "233", "2" = "467", "3" = "700")

levels(EXP1.T1.plot$data$TrialType) <- c("1" = "No Selection", "2" = "Selection")

levels(EXP1.T2.plot$data$TrialType) <- c("1" = "No Selection", "2" = "Selection")

levels(EXP1.T1.plot$data$CueType) <- c("1" = "Informative", "2" = "Uninformative")

levels(EXP1.T2.plot$data$CueType) <- c("1" = "Informative", "2" = "Uninformative")

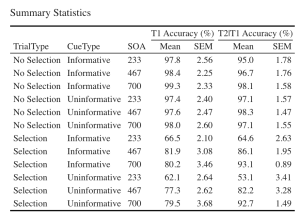

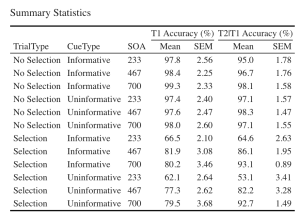

7. Créons un magnifique tableau HTML imprimable des statistiques récapitulatives pour les scores T1 et T2. Ce tableau récapitulatif peut ensuite être utilisé dans votre manuscrit. Je vous suggère de visiter le lien suivant pour obtenir des guides sur la façon de créer des tableaux imprimables. Personnalisation du tableau HTML

- Commencez par extraire les données de statistiques sommaires avec les moyennes de groupe et les valeurs SEM de CousineauMorey de chaque fonction de tracé et enregistrez-les en tant que cadre de données séparément pour les données T1 et T2 (vous devriez avoir deux cadres de données avec vos statistiques sommaires nommés “EXP1.T1.summaryData” et “EXP1.T2.summaryData”).

- Dans vos deux cadres de données avec les statistiques sommaires, arrondissez vos moyennes à une décimale et vos valeurs SEM à deux décimales.

- Fusionnez les données récapitulatives de T1Score et T2Score et enregistrez-les sous “EXP1_summarystat_results”

- Dans ce tableau fusionné, supprimez les colonnes contenant les valeurs SEM négatives (valeurs SEM de largeur inférieure).

- Renommez les colonnes de ce cadre de données fusionné de sorte que le nom des colonnes contenant les moyennes T1Score et T2Score soit “Means” et que les colonnes contenant les scores SEM pour l’une ou l’autre des variables dépendantes soient “SEM”.

- Intitulez votre tableau “Statistiques sommaires”

- Réglez la police de votre texte sur “Cambria” et la taille de la police sur 14.

- Définissez les en-têtes des colonnes T1Score means et SEM comme “T1 Accuracy (%)”.

- Définissez les en-têtes des colonnes T2Score means et SEM comme “T2 Accuracy (%)”.

# Extracting summary data with CousineauMorey SEM Bars

EXP1.T1.summaryData <- data.frame(EXP1.T1.plot$data)

EXP1.T2.summaryData <- data.frame(EXP1.T2.plot$data)

# Rounding values in each column

# round(x, 1) rounds to the specified number of decimal places

EXP1.T1.summaryData$center <- round(EXP1.T1.summaryData$center,1)

EXP1.T1.summaryData$upperwidth <- round(EXP1.T1.summaryData$upperwidth,2)

EXP1.T2.summaryData$center <- round(EXP1.T2.summaryData$center,1)

EXP1.T2.summaryData$upperwidth <- round(EXP1.T2.summaryData$upperwidth,2)

# merging T1 and T2|T1 summary tables

EXP1_summarystat_results <- merge(EXP1.T1.summaryData, EXP1.T2.summaryData, by=c("TrialType","CueType","SOA"))

# Rename the column name

colnames(EXP1_summarystat_results)[colnames(EXP1_summarystat_results) == "center.x"] ="Mean"

colnames(EXP1_summarystat_results)[colnames(EXP1_summarystat_results) == "center.y"] ="Mean"

colnames(EXP1_summarystat_results)[colnames(EXP1_summarystat_results) == "upperwidth.x"] ="SEM"

colnames(EXP1_summarystat_results)[colnames(EXP1_summarystat_results) == "upperwidth.y"] ="SEM"

# deleting columns by name "lowerwidth.x" and "lowerwidth.y" in each summary table

EXP1_summarystat_results <- EXP1_summarystat_results[ , ! names(EXP1_summarystat_results) %in% c("lowerwidth.x", "lowerwidth.y")]

#removing suffixes from column names

colnames(EXP1_summarystat_results)<-gsub(".1","",colnames(EXP1_summarystat_results))

# Printable ANOVA html

EXP1_summarystat_results %>%

kbl(caption = "Summary Statistics") %>%

kable_classic(full_width = F, html_font = "Cambria", font_size = 14) %>%

add_header_above(c(" " = 3, "T1 Accuracy (%)" = 2, "T2|T1 Accuracy (%)" = 2))

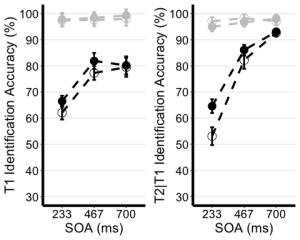

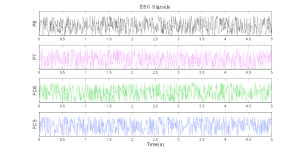

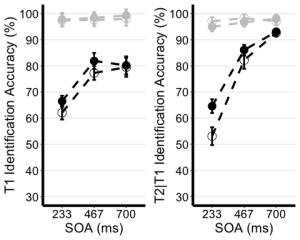

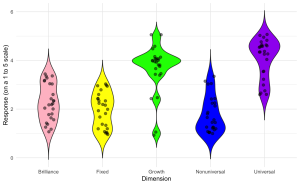

Exercice 3 – Visualiser les données

8. Utilisez le tableau de statistiques récapitulatives non édité de l’exercice 2 (EXP1.T1.summaryData et EXP1.T3.summaryData) et la fonction ggplot() pour créer des graphiques linéaires récapitulatifs distincts pour les scores T1 et T2. Le graphique linéaire visualise la relation entre la SOA et la mesure dépendante tout en tenant compte des facteurs de type de repère et de type d’essai. Votre graphique doit présenter les caractéristiques suivantes :

- Tracer le SOA sur l’axe des abscisses et l’intituler “SOA (ms)”

- Tracez la mesure dépendante sur l’axe des ordonnées et intitulez l’axe des ordonnées “Précision d’identification T1” pour le tracé T1, et “Précision d’identification T2|T1 (%)” pour le tracé T2.

- Définissez la couleur de vos lignes en fonction du type d’essai.

- Définissez la forme des points pour chaque valeur de la ligne par type d’indice.

- Utilisez la fonction geom_point() pour personnaliser la forme de vos points. Utilisez des cercles pleins pour les indices informatifs et des cercles creux pour les indices non informatifs.

- Utilisez la fonction scale_color_manual() pour personnaliser les couleurs des lignes. Réglez la couleur des lignes représentant les essais de sélection sur “black” et celle des lignes représentant les essais de non-sélection sur “gray78”.

- Utilisez geom_line() pour personnaliser le type de ligne. Réglez le type de ligne sur pointillé et la largeur de ligne sur 1,2.

- Personnalisez votre axe des y. Fixez la valeur minimale à 30 et la valeur maximale à 100.

- Utilisez la fonction scale_y_continuous() pour que les valeurs de l’axe des y augmentent par incréments de 10.

- Utilisez la fonction geom_errorbar() pour tracer des barres d’erreur en utilisant les valeurs SEM calculées dans le tableau récapitulatif.

- Définissez le thème du tracé sur theme_classic()

- Utilisez la fonction theme() pour personnaliser la taille de la police de l’axe des x et la largeur des lignes. Modifier la taille de la police du titre principal de l’axe à 16, et les étiquettes de l’axe des x à 14.

- Ajoutez des lignes de grille horizontales.

- Ne pas inclure de légende.

- Stockez vos deux graphiques sous les noms “T1.ggplotplot” et “T2.ggplotplot”

EXP1.T1.ggplotplot <- ggplot(EXP1.T1.summaryData, aes(x=SOA, y=center, color=TrialType, shape = CueType,

group=interaction(CueType, TrialType))) +

geom_point(data=filter(EXP1.T1.summaryData, CueType == "Uninformative"), shape=1, size=4.5) + # assigning shape type to level of factor

geom_point(data=filter(EXP1.T1.summaryData, CueType == "Informative"), shape=16, size=4.5) + # assigning shape type to level of factor

geom_line(linetype="dashed", linewidth=1.2) + # change line thickness and line style

scale_color_manual(values = c("gray78", "black") ) +

xlab("SOA (ms)") +

ylab("T1 Identification Accuracy (%)") +

theme_classic() + # It has no background, no bounding box.

theme(axis.line=element_line(size=1.5), # We make the axes thicker...

axis.text = element_text(size = 14, colour = "black"), # their text bigger...

axis.title = element_text(size = 16, colour = "black"), # their labels bigger...

panel.grid.major.y = element_line(), # adding horizontal grid lines

legend.position = "none") +

coord_cartesian(ylim=c(30, 100)) +

scale_y_continuous(breaks=seq(30, 100, 10)) + # Ticks from 30-100, every 10

geom_errorbar(aes(ymin=center+lowerwidth, ymax=center+upperwidth), width = 0.12, size = 1) # adding error bars from summary table

EXP1.T2.ggplotplot <- ggplot(EXP1.T2.summaryData, aes(x=SOA, y=center, color=TrialType, shape=CueType,

group=interaction(CueType, TrialType))) +

geom_point(data=filter(EXP1.T2.summaryData, CueType == "Uninformative"), shape=1, size=4.5) + # assigning shape type to level of factor

geom_point(data=filter(EXP1.T2.summaryData, CueType == "Informative"), shape=16, size=4.5) + # assigning shape type to level of factor

geom_line(linetype="dashed", linewidth=1.2) + # change line thickness and line style

scale_color_manual(values = c("gray78", "black")) +

xlab("SOA (ms)") +

ylab("T2|T1 Identification Accuracy (%)") +

theme_classic() + # It has no background, no bounding box.

theme(axis.line=element_line(size=1.5), # We make the axes thicker...

axis.text = element_text(size = 14, colour = "black"), # their text bigger...

axis.title = element_text(size = 16, colour = "black"), # their labels bigger...

panel.grid.major.y = element_line(), # adding horizontal grid lines

legend.position = "none") +

guides(fill = guide_legend(override.aes = list(shape = 16) ),

shape = guide_legend(override.aes = list(fill = "black"))) +

coord_cartesian(ylim=c(30, 100)) +

scale_y_continuous(breaks=seq(30, 100, 10)) + # Ticks from 30-100, every 10

geom_errorbar(aes(ymin=center+lowerwidth, ymax=center+upperwidth), width = 0.12, size = 1) # adding error bars from summary table

9. Utilisez ggarrange() pour afficher vos tracés ensemble.

ggarrange(EXP1.T1.ggplotplot, EXP1.T2.ggplotplot,

nrow = 1, ncol = 2, common.legend = F,

widths = 8, heights = 5)

Exercice 4 – L’analyse principale

Étant donné que les performances des essais de non-sélection sont proches du plafond (près de 100 %), nous concentrerons nos analyses sur les essais de sélection.

10. Utilisez les données en format long (“cueingData”) et la fonction anova_test(), et calculez une ANOVA à deux voies pour chaque variable dépendante, mais sur les essais de sélection uniquement. Définissez le type de repère et l’AOS comme facteurs internes aux participants. (Conseil : utilisez la fonction filter())

- Réglez votre mesure de l’ampleur de l’effet sur l’éta quadratique partiel (pes).

- Assurez-vous de générer le tableau ANOVA détaillé.

- Enregistrez vos calculs et “T1_2anova” et “T2_2anova”.

- Utilisez la fonction get_anova_table() pour afficher vos tableaux d’ANOVA.

T1_2anova <- anova_test(

data = filter(cueingData, TRIAL_TYPE == "S"), dv = T1Score, wid = ID,

within = c(CUE_TYPE, SOA), detailed = TRUE, effect.size = "pes")

T2_2anova <- anova_test(

data = filter(cueingData, TRIAL_TYPE == "S"), dv = T2Score, wid = ID,

within = c(CUE_TYPE, SOA), detailed = TRUE, effect.size = "pes")

get_anova_table(T1_2anova)

## ANOVA Table (type III tests)

##

## Effect DFn DFd SSn SSd F p p<.05 pes

## 1 (Intercept) 1.00 15.00 534043.211 30705.523 260.886 6.80e-11 * 0.946

## 2 CUE_TYPE 1.00 15.00 253.665 506.454 7.513 1.50e-02 * 0.334

## 3 SOA 1.29 19.35 5091.853 2660.275 28.710 1.16e-05 * 0.657

## 4 CUE_TYPE:SOA 2.00 30.00 77.140 1061.051 1.091 3.49e-01 0.068

get_anova_table(T2_2anova)

## ANOVA Table (type III tests)

##

## Effect DFn DFd SSn SSd F p p<.05 pes

## 1 (Intercept) 1 15 593913.106 11288.706 789.169 2.19e-14 * 0.981

## 2 CUE_TYPE 1 15 661.761 426.947 23.250 2.24e-04 * 0.608

## 3 SOA 2 30 20001.563 3852.629 77.875 1.33e-12 * 0.838

## 4 CUE_TYPE:SOA 2 30 519.154 1298.144 5.999 6.00e-03 * 0.286

Exercice 5 – Les tests post-hoc

S’il existe une interaction bidirectionnelle significative, cela signifie que l’impact d’un facteur est influencé par un autre facteur. Cela signifie que les deux variables indépendantes interagissent l’une avec l’autre pour produire un effet significatif sur la variable dépendante. Étant donné qu’il existe une interaction bidirectionnelle significative entre le type de repère et l’AOS pour les scores T2, nous devons procéder à des tests post hoc afin d’explorer et de comprendre les différences spécifiques entre les niveaux ou les conditions des facteurs impliqués dans l’interaction. Cela peut nous aider à identifier les combinaisons spécifiques à l’origine de l’effet d’interaction.

11. Filtrez d’abord les essais de sélection, puis regroupez vos données par SOA et utilisez la fonction pairwise_t_test() pour comparer les essais informatifs et non informatifs à chaque niveau de SOA, stockez et affichez votre calcul sous la forme “T2_sel_pwc”.

T2_sel_pwc <- filter(cueingData, TRIAL_TYPE == "S") %>%

group_by(SOA) %>%

pairwise_t_test(T2Score ~ CUE_TYPE, paired = TRUE, p.adjust.method = "holm", detailed = TRUE) %>%

add_significance("p.adj")

T2_sel_pwc <- get_anova_table(T2_sel_pwc)

T2_sel_pwc

## # A tibble: 3 × 16

## SOA estimate .y. group1 group2 n1 n2 statistic p df

## <fct> <dbl> <chr> <chr> <chr> <int> <int> <dbl> <dbl> <dbl>

## 1 233 11.5 T2Score INFORMATIVE UNINFO… 16 16 4.36 5.55e-4 15

## 2 467 3.89 T2Score INFORMATIVE UNINFO… 16 16 1.97 6.8 e-2 15

## 3 700 0.356 T2Score INFORMATIVE UNINFO… 16 16 0.190 8.52e-1 15

## # ℹ 6 more variables: conf.low <dbl>, conf.high <dbl>, method <chr>,

## # alternative <chr>, p.adj <dbl>, p.adj.signif <chr>

Remarques finales

Superbe travail !

Vous avez réussi à reconstruire une figure et à effectuer des analyses dans le cadre d’un projet de mémoire de maîtrise. Les données sur lesquelles vous avez travaillé ont été recueillies dans le laboratoire d’attention et de mémoire du département de psychologie, de neuroscience et de comportement (PNB) de l’Université McMaster. Ce laboratoire prospère sous l’égide du Dr Bruce Milliken, dont les recherches sont profondément ancrées dans le domaine de la cognition humaine. L’objectif principal du laboratoire est d’élucider les processus fondamentaux qui sous-tendent l’attention, la mémoire et le contrôle cognitif. L’étendue des recherches menées ici englobe un large éventail de sujets. Il s’agit notamment d’étudier les nuances qui différencient les processus mentaux conscients et inconscients, d’explorer la manière dont les mécanismes attentionnels influencent et soutiennent l’apprentissage et la mémoire, de comprendre le rôle de l’imagerie visuelle dans la formation de l’attention et de la perception, et d’examiner l’impact de l’apprentissage implicite sur l’orchestration du contrôle de l’attention. Chaque projet au sein de ce laboratoire témoigne de l’engagement à faire progresser notre compréhension de la tapisserie complexe de la cognition humaine.

Références et lectures complémentaires :

Si vous souhaitez approfondir l’ensemble des données et les spécificités du projet de thèse, je vous encourage à explorer la thèse de doctorat librement accessible ou l’article publié cité ci-dessous :

Montakhaby Nodeh, S., MacLellan, E., & Milliken, B. (2024). Proactive control: Endogenous cueing effects in a two-target attentional blink task. Consciousness and Cognition, 118, 103648. Elsevier BV. https://doi.org/10.1016/j.concog.2024.103648

P02: Laboratoire de cognition et de mémoire

Sevda Montakhaby Nodeh

Laboratoire de cognition et de mémoire

Bienvenue ! Dans le cadre de cette tâche, nous allons entrer dans un laboratoire de cognition et de mémoire de l’Université McMaster. Plus précisément, nous examinerons les données d’une étude fascinante de psychologie cognitive qui explore le rôle de la répétition dans la mémoire de reconnaissance.

La plupart d’entre nous connaissent l’expression “c’est en forgeant qu’on devient forgeron”. Cette expression motivante correspond à l’intuition et est confirmée par de nombreuses observations dans le monde réel. De nombreuses recherches empiriques soutiennent également ce point de vue : les occasions répétées d’encoder un stimulus améliorent la récupération ultérieure de la mémoire et l’identification perceptuelle. Ces observations suggèrent que la répétition d’un stimulus renforce les représentations sous-jacentes dans la mémoire.

La présente étude se concentre sur une idée contradictoire, à savoir que la répétition d’un stimulus peut affaiblir l’encodage de la mémoire. L’expérience comprenait trois étapes : une phase d’étude, une phase de distraction et un test de mémoire de reconnaissance surprise.

La présente étude se concentre sur une idée contradictoire, à savoir que la répétition du stimulus peut affaiblir l’encodage de la mémoire. L’expérience comprenait trois étapes : une phase d’étude, une phase de distraction et un test de mémoire de reconnaissance par surprise.

Dans la phase d’étude, les participants prononcent à haute voix un mot cible rouge précédé d’un mot premier vert brièvement présenté. Sur la moitié des essais, le mot principal et le mot cible étaient identiques (essais répétés), et sur l’autre moitié des essais, le mot principal et le mot cible étaient différents (essais non répétés). La figure ci-dessous donne un aperçu des deux types d’essais. Après la phase d’étude, les participants se sont livrés à une tâche de distraction de 10 minutes consistant en des problèmes mathématiques qu’ils devaient résoudre à la main.

La phase finale consistait en un test de mémoire de reconnaissance surprise où, à chaque essai, on leur montrait un mot rouge et on leur demandait de répondre “ancien” si le mot du test était un mot qu’ils avaient déjà vu à l’étude, et “nouveau” s’ils n’avaient jamais rencontré ce mot auparavant. La moitié des essais du test étaient des mots de la phase d’étude et l’autre moitié des mots nouveaux.

Commençons par exécuter le code suivant pour charger les bibliothèques requises. Veillez à lire les commentaires intégrés dans le code pour comprendre ce que fait chaque ligne de code.

Remarque : les cases grisées contiennent le code R, le signe “#” indiquant un commentaire qui ne s’exécutera pas dans RStudio

# Load necessary libraries

library(rstatix) #for performing basic statistical tests

library(dplyr) #for sorting data

library(readxl) #for reading excel files

library(tidyr) #for data sorting and structure

library(ggplot2) #for visualizing your data

library(plotrix) #for computing basic summary stats

Assurez-vous d’avoir téléchargé l’ensemble de données requis (“RepDecrementdataset.xlsx”) pour cet exercice. Définissez le répertoire de travail de votre session R actuelle dans le dossier contenant l’ensemble de données téléchargé. Vous pouvez le faire manuellement dans le studio R en cliquant sur l’onglet “Session” en haut de l’écran, puis en cliquant sur “Set Working Directory”.

Si le fichier de données téléchargé et votre session R se trouvent dans le même dossier, vous pouvez choisir de définir votre répertoire de travail sur “l’emplacement du fichier source” (l’emplacement où votre session R actuelle est sauvegardée). S’ils se trouvent dans des dossiers différents, cliquez sur l’option “choisir un répertoire” et recherchez l’emplacement du jeu de données téléchargé.

Vous pouvez également effectuer cette opération en exécutant le code suivant

Une fois que vous avez défini votre répertoire de travail, manuellement ou par code, la console ci-dessous affiche le répertoire complet de votre dossier.

Lisez l’ensemble de données téléchargé en tant que “MemoryData” et effectuez les exercices qui l’accompagnent au mieux de vos capacités.

MemoryData <- read_excel('RepDecrementdataset.xlsx')

Fichiers à télécharger :

- RepDecrementdataset.xlsx

An interactive H5P element has been excluded from this version of the text. You can view it online here:

https://ecampusontario.pressbooks.pub/rspnc/?p=148#h5p-2

Solutions

Exercice 1 – Préparation et exploration des données

Remarque : les cases grisées contiennent le code R, tandis que les cases blanches affichent la sortie du code, telle qu’elle apparaît dans RStudio.

Le signe “#” indique un commentaire qui ne sera pas exécuté dans RStudio.

1. Affichez les premières lignes de votre jeu de données pour vous familiariser avec sa structure et son contenu.

head(MemoryData) #Displaying the first few rows

## # A tibble: 6 × 7

## ID Hits_NRep Hits_Rep FalseAlarms Misses_Nrep Misses_Rep CorrectRej

## <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

## 1 1 46 34 13 14 26 107

## 2 2 43 44 27 17 16 93

## 3 3 43 35 23 17 24 97

## 4 4 37 36 56 23 24 64

## 5 5 39 35 49 21 25 71

## 6 6 38 43 28 22 17 92

str(MemoryData) #Checking structure of dataset

## tibble [24 × 7] (S3: tbl_df/tbl/data.frame)

## $ ID : num [1:24] 1 2 3 4 5 6 7 8 9 10 ...

## $ Hits_NRep : num [1:24] 46 43 43 37 39 38 20 24 36 38 ...

## $ Hits_Rep : num [1:24] 34 44 35 36 35 43 11 29 43 27 ...

## $ FalseAlarms: num [1:24] 13 27 23 56 49 28 4 11 46 9 ...

## $ Misses_Nrep: num [1:24] 14 17 17 23 21 22 40 36 23 22 ...

## $ Misses_Rep : num [1:24] 26 16 24 24 25 17 49 31 17 33 ...

## $ CorrectRej : num [1:24] 107 93 97 64 71 92 116 109 74 111 ...

## [1] "ID" "Hits_NRep" "Hits_Rep" "FalseAlarms" "Misses_Nrep"

## [6] "Misses_Rep" "CorrectRej"

2. Calculer le nombre total d’essais pour chaque condition :

- (a) Pour chaque participant, additionnez le nombre de réponses positives pour les essais non répétés et les essais non répétés manqués. Enregistrez ce total dans une nouvelle colonne intitulée “TotalNRep”. La valeur doit être de 60 pour tous les participants, ce qui correspond au nombre total de types d’essais non répétés.

- (b) Répétez le processus pour les essais répétés, en enregistrant la somme dans “TotalRep” (60 essais).

- (c) De même, additionnez le nombre de fausses alarmes et de rejets corrects pour représenter le nombre total de nouveaux essais (120 essais) et enregistrez cette somme dans “TotalNew”.

Notez que si la valeur de “TotalNRep” et “TotalRep” est inférieure à 60 pour un participant, cela indique que certains essais de mots ont été exclus pendant la phase d’étude en raison de problèmes (par exemple, le participant a lu à haute voix le mot principal au lieu du mot cible, ce qui a entraîné la détérioration de l’essai).

MemoryData <- MemoryData %>%

mutate(TotalNRep = Hits_NRep + Misses_Nrep)

MemoryData <- MemoryData %>%

mutate(TotalRep = Hits_Rep + Misses_Rep)

MemoryData <- MemoryData %>%

mutate(TotalNew = FalseAlarms + CorrectRej)

3. Transformez les nombres des colonnes “hits”, “misses”, “false alarms” et “correct rejections” en proportions. Pour ce faire, divisez chaque nombre par le nombre total d’essais pour la condition concernée (par exemple, divisez les réponses positives pour les essais non répétés par “TotalNRep”).

MemoryData$Hits_NRep <- (MemoryData$Hits_NRep/MemoryData$TotalNRep)

MemoryData$Misses_Nrep <- (MemoryData$Misses_Nrep/MemoryData$TotalNRep)

MemoryData$Hits_Rep <- (MemoryData$Hits_Rep/MemoryData$TotalRep)

MemoryData$Misses_Rep <- (MemoryData$Misses_Rep/MemoryData$TotalRep)

MemoryData$CorrectRej <- (MemoryData$CorrectRej/MemoryData$TotalNew)

MemoryData$FalseAlarms <- (MemoryData$FalseAlarms/MemoryData$TotalNew)

4. Une fois les proportions calculées, supprimez les colonnes “TotalNew”, “TotalRep” et “TotalNRep” de l’ensemble de données, car elles ne sont plus nécessaires pour la suite de l’analyse.

MemoryData <- MemoryData[, !names(MemoryData) %in% c("TotalNew", "TotalRep","TotalNRep")]

5. Utilisez la fonction pivot_longer() du package tidyr pour convertir vos données du format large au format long. Effectuez un pivot des colonnes “Hits_NRep”, “Hits_Rep” et “FalseAlarms”, en définissant les nouveaux noms de colonnes “Condition” et “Proportion” pour les données remodelées.

long_df <- MemoryData %>%

pivot_longer(

cols = c(Hits_NRep, Hits_Rep, FalseAlarms),

names_to = "Condition",

values_to = "Proportion"

)

Exercice 2 : Calcul des statistiques sommaires et correction de la variabilité intra-sujet

6. À l’aide de votre ensemble de données au format long, regroupez vos données par ID et calculez la moyenne par sujet et la moyenne générale de la colonne Proportions.

- (a) Ajustez le score de chaque individu en soustrayant sa moyenne et en ajoutant la moyenne générale.

- (b) Calculez la moyenne et le SEM des scores ajustés pour chaque condition.

- (c) Utilisez les scores ajustés pour calculer le SEM intra-sujet. d.Regroupez les données par condition et calculez la moyenne et le SEM.

data_adjusted <- long_df %>%

group_by(ID) %>%

mutate(SubjectMean = mean(Proportion, na.rm = TRUE)) %>%

ungroup() %>%

mutate(GrandMean = mean(Proportion, na.rm = TRUE)) %>%

mutate(AdjustedScore = Proportion - SubjectMean + GrandMean)

# Calculate the mean and SEM of the adjusted scores

summary_df <- data_adjusted %>%

group_by(Condition) %>%

summarize(

AdjustedMean = mean(AdjustedScore, na.rm = TRUE),

AdjustedSEM = sd(AdjustedScore, na.rm = TRUE) / sqrt(n())

)

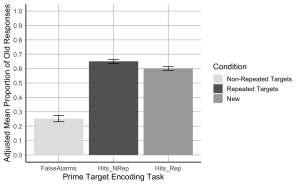

Exercice 3 : Visualisation des données

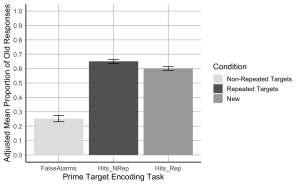

7. Créez un diagramme à barres où l’axe x représente les conditions de la tâche d’encodage de l’amorce et de la cible, l’axe y montre la proportion moyenne ajustée des anciennes réponses, et les barres d’erreur représentent le SEM ajusté. Commencez par définir des couleurs personnalisées pour chaque condition. La couleur de la barre présentant les fausses alarmes ou “New” doit être “gray89” ; la couleur de la barre “Hits_Nrep” ou “Non-Repeated Targets” doit être “gray39” ; la couleur de la barre “Hits_Rep” ou “Repeated Targets” doit être “darkgrey”.

- (a) L’axe des x doit être intitulé “tâche d’encodage de la cible principale”.

- (b) L’axe des ordonnées doit être intitulé “Proportion moyenne corrigée des anciennes réponses”

- (c) Ajoutez des barres d’erreur à chaque barre pour représenter le SEM corrigé.

- (d) Faites en sorte que les lignes des axes x et y soient noires et pleines.

- (e) Veillez à ce que le graphique soit minimaliste et ne comporte que les principales lignes de la grille.

- (f) Ajouter une légende pour indiquer les catégories de conditions. La légende doit être la suivante : cibles non répétées au lieu de “Hits_Nrep”, cibles répétées au lieu de “Hits_Rep”, et nouvelles au lieu de “Fausses alarmes”.

- (g) Fixez les valeurs minimale et maximale de l’axe des y à 0 et 1, respectivement.

- (h) Les valeurs de l’axe des y doivent augmenter de 0,1.

# Create the bar plot with adjusted SEM error bars

ggplot(summary_df, aes(x = Condition, y = AdjustedMean, fill = Condition)) +

geom_bar(stat = "identity", position = position_dodge()) +

geom_errorbar(aes(ymin = AdjustedMean - AdjustedSEM, ymax = AdjustedMean + AdjustedSEM), width = 0.2, position = position_dodge(0.9)) +

scale_fill_manual(values = c("Hits_NRep" = "gray39", "Hits_Rep" = "darkgrey", "FalseAlarms" = "gray89"),

labels = c("Non-Repeated Targets", "Repeated Targets", "New")) +

labs(

x = "Prime Target Encoding Task",

y = "Adjusted Mean Proportion of Old Responses",

fill = "Condition"

) +

scale_y_continuous(breaks = seq(0, 1, by = 0.1), limits = c(0, 1)) +

theme_minimal(base_size = 14) +

theme(

axis.line = element_line(color = "black"),

axis.title = element_text(color = "black"),

panel.grid.major = element_line(color = "grey", size = 0.5),

panel.grid.minor = element_blank(),

legend.title = element_text(color = "black")

)

Exercice 4 – L’analyse principale

8. À l’aide du fichier de données au format large “MemoryData”, effectuez un test t à deux échantillons appariés en comparant le taux de réussite cumulé dans les deux conditions de répétition (répété/non répété) au taux de fausses alarmes pour évaluer la capacité des participants à distinguer les anciens éléments des nouveaux.

- (a) Calculez le taux de réussite moyen en faisant la moyenne des taux de réussite des conditions “Hits_NRep” (non répété) et “Hits_Rep” (répété) pour chaque participant.

- (b) Effectuez un test t pour échantillons appariés afin de comparer le taux de réussite (combiné dans les deux conditions de répétition) au taux de fausses alarmes afin d’évaluer la capacité des participants à distinguer les anciens éléments des nouveaux.

collapsed_hitdata <- MemoryData %>%

mutate(HitRate = (Hits_NRep + Hits_Rep) / 2)

# Conduct paired sample t-tests

t_test_results <- t.test(collapsed_hitdata$HitRate, collapsed_hitdata$FalseAlarms, paired = TRUE)

print(t_test_results)

##

## Paired t-test

##

## data: collapsed_hitdata$HitRate and collapsed_hitdata$FalseAlarms

## t = 11.621, df = 23, p-value = 4.179e-11

## alternative hypothesis: true mean difference is not equal to 0

## 95 percent confidence interval:

## 0.3071651 0.4401983

## sample estimates:

## mean difference

## 0.3736817

#Hit rates were higher than false alarm rates, t(23) = 11.62, p < .001.

9. En utilisant le fichier de données au format large “MemoryData”, effectuez un test t à deux échantillons appariés comparant les taux de réussite pour les cibles non répétées et répétées.

# Conduct paired sample t-tests for non-repeated vs repeated hit rates

t_test_results_hits <- t.test(collapsed_hitdata$Hits_NRep, collapsed_hitdata$Hits_Rep, paired = TRUE)

# Print the results for the hit rate comparison

print(t_test_results_hits)

##

## Paired t-test

##

## data: collapsed_hitdata$Hits_NRep and collapsed_hitdata$Hits_Rep

## t = 2.5431, df = 23, p-value = 0.01817

## alternative hypothesis: true mean difference is not equal to 0

## 95 percent confidence interval:

## 0.009071364 0.088174399

## sample estimates:

## mean difference

## 0.04862288

#Hit rates were higher for not-repeated targets than for repeated targets, t(23) = 2.54, p = .018.

P03: Laboratoire de développement de la petite enfance

Sevda Montakhaby Nodeh

Laboratoire de développement de la petite enfance

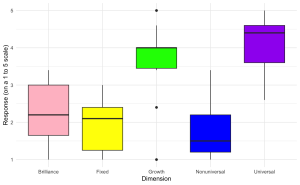

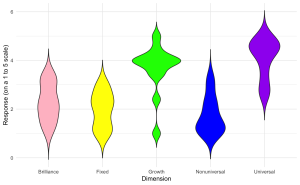

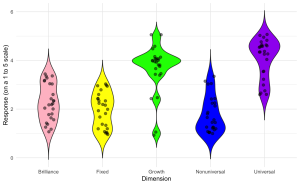

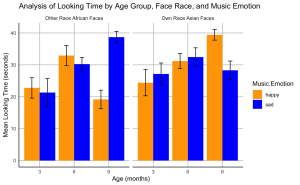

Vous êtes chercheur au Centre de recherche sur le développement de la petite enfance. Votre dernier projet porte sur la manière dont les nourrissons réagissent à différentes combinaisons de visages, de races et d’émotions musicales. Plus précisément, vous vous intéressez à la question de savoir si les enfants associent des visages de leur propre race et d’autres races à des musiques de différentes valences émotionnelles (musique joyeuse et musique triste).

Votre projet a été réalisé en collaboration avec vos collègues en Chine. Alors que vous étiez responsable de la conception de votre expérience, vos collaborateurs étaient chargés de recruter les participants et de collecter les données.

Des bébés chinois (âgés de 3 à 9 mois) ont été recrutés pour participer à votre expérience. Chaque enfant a été assigné au hasard à l’une des quatre conditions visage-race + musique dans lesquelles il voyait une série de visages neutres de sa propre race ou d’une autre race associés à des extraits musicaux joyeux ou tristes.

- Propre race + condition de musique joyeuse (own-happy)

- Propre race + musique triste (own-sad)

- Autre race + musique heureuse (autre-heureux)

- Autre race + musique triste (autre-mal)

Dans le cadre de l’expérience “own-happy”, les enfants ont regardé six vidéos de visages asiatiques associées de manière séquentielle à six extraits musicaux joyeux. Dans l’autre condition, les enfants ont regardé six vidéos de visages africains associés séquentiellement à des extraits musicaux joyeux. En général, les conditions étaient identiques sur le plan procédural, à l’exception de la composition du visage et de la musique. Les mouvements oculaires des enfants ont été enregistrés à l’aide d’un système de suivi des yeux.

Votre objectif est de déterminer comment la race du visage et l’émotion de la musique, ainsi que leur interaction, influencent le comportement des nourrissons en matière de regard.

Vos variables indépendantes :

- Visage.race(chinois/africain)

- Musique.émotion(joyeux/triste)

Vos variables dépendantes :

- First.Face.Looking.Time : il s’agit du temps de regard sur la vidéo du premier visage dans les quatre conditions.

- Total.Looking.Time : Somme des temps de regard de chaque enfant sur les cinq visages suivants pour créer une mesure de leur temps de regard total sur les cinq visages après.

Commençons par charger les bibliothèques nécessaires et le jeu de données “BabyData”. Pour ce faire, téléchargez le fichier “infant_eye_tracking_study.csv” et exécutez le code suivant. N’oubliez pas de remplacer ‘path_to_your_downloaded_file’ par le chemin réel du jeu de données sur votre système.

Remarque : les cases grisées contiennent le code R, le signe “#” indiquant un commentaire qui ne s’exécutera pas dans RStudio.

BabyData <- read.csv('path_to_your_downloaded_file/infant_eye_tracking_study.csv')

library(rstatix) #for performing basic statistical tests

library(dplyr) #for sorting data

library(tidyr) #for data sorting and structure

library(ggplot2) #for visualizing your data

library(readr)

library(ggpubr)

library(gridExtra)

Fichiers à télécharger :

- infant_eye_tracking_study.csv

Veuillez compléter les exercices ci-joints au mieux de vos capacités.

An interactive H5P element has been excluded from this version of the text. You can view it online here:

https://ecampusontario.pressbooks.pub/rspnc/?p=152#h5p-3

Solutions

Exercice 1 – Préparation et exploration des données

Remarque : les cases grisées contiennent le code R, tandis que les cases blanches affichent la sortie du code, telle qu’elle apparaît dans RStudio.

Le signe “#” indique un commentaire qui ne sera pas exécuté dans RStudio.

1. Affichez les premières lignes pour comprendre votre jeu de données.

summary(BabyData) # Viewing the summary of the dataset to check for inconsistencies

## Age.in.Days Condition Face.Race Music.Emotion Age.Group

## 1 93 Other-Race Happy Music African happy 3

## 2 98 Other-Race Happy Music African happy 3

## 3 93 Other-Race Happy Music African happy 3

## 4 93 Other-Race Happy Music African happy 3

## 5 93 Other-Race Happy Music African happy 3

## 6 100 Other-Race Happy Music African happy 3

## Total.Looking.Time First.Face.Looking.Time Participant.ID

## 1 44.035 8.273 HJOGM7704U

## 2 18.324 6.938 JHSEG5414N

## 3 24.600 4.225 OCQFX4970K

## 4 12.919 7.537 KLDOF5559R

## 5 12.755 4.230 HHPGJ9661Y

## 6 38.777 9.351 NVCPX9518V

2. Utilisez relocate() pour réorganiser vos colonnes de manière à ce que la colonne “Participant.ID” apparaisse comme la première colonne de votre ensemble de données.

BabyData <- BabyData %>% relocate(Participant.ID, .before = Age.in.Days)

3. Vérifiez que vos données ne comportent pas de valeurs manquantes. Supprimez de l’ensemble de données toutes les lignes contenant des valeurs manquantes ou NA.

sum(is.na(BabyData)) # Checking for missing values in the dataset

BabyData <- BabyData[!is.na(BabyData$First.Face.Looking.Time), ]

## Participant.ID Age.in.Days Condition Face.Race

## Length:193 Min. : 79.0 Length:193 Length:193

## Class :character 1st Qu.:127.0 Class :character Class :character

## Mode :character Median :185.0 Mode :character Mode :character

## Mean :189.3

## 3rd Qu.:246.0

## Max. :316.0

##

## Music.Emotion Age.Group Total.Looking.Time First.Face.Looking.Time

## Length:193 Min. :3.000 Min. : 1.654 Min. : 0.160

## Class :character 1st Qu.:3.000 1st Qu.:20.671 1st Qu.: 5.309

## Mode :character Median :6.000 Median :30.381 Median : 7.495

## Mean :6.093 Mean :29.196 Mean : 7.041

## 3rd Qu.:9.000 3rd Qu.:38.196 3rd Qu.: 9.185

## Max. :9.000 Max. :50.000 Max. :11.823

## NA's :3

4. Vérifiez à nouveau que vos données ne comportent pas de valeurs manquantes et que les données sont cohérentes.

sum(is.na(BabyData)) # Checking for missing values in the dataset

summary(BabyData) # Viewing the summary of the dataset to check for inconsistencies

## Participant.ID Age.in.Days Condition Face.Race

## Length:193 Min. : 79.0 Length:193 Length:193

## Class :character 1st Qu.:127.0 Class :character Class :character

## Mode :character Median :185.0 Mode :character Mode :character

## Mean :189.3

## 3rd Qu.:246.0

## Max. :316.0

##

## Music.Emotion Age.Group Total.Looking.Time First.Face.Looking.Time

## Length:193 Min. :3.000 Min. : 1.654 Min. : 0.160

## Class :character 1st Qu.:3.000 1st Qu.:20.671 1st Qu.: 5.309

## Mode :character Median :6.000 Median :30.381 Median : 7.495

## Mean :6.093 Mean :29.196 Mean : 7.041

## 3rd Qu.:9.000 3rd Qu.:38.196 3rd Qu.: 9.185

## Max. :9.000 Max. :50.000 Max. :11.823

## NA's :0

5. Vérifiez la structure et assurez-vous que vos colonnes factorielles (Music.Emotion, Face.Race et Condition) sont correctement configurées.

## 'data.frame': 190 obs. of 8 variables:

## $ Participant.ID : chr "HJOGM7704U" "JHSEG5414N" "OCQFX4970K" "KLDOF5559R" ...

## $ Age.in.Days : int 93 98 93 93 93 100 93 91 98 100 ...

## $ Condition : chr "Other-Race Happy Music" "Other-Race Happy Music" "Other-Race Happy Music" "Other-Race Happy Music" ...

## $ Face.Race : chr "African" "African" "African" "African" ...

## $ Music.Emotion : chr "happy" "happy" "happy" "happy" ...

## $ Age.Group : int 3 3 3 3 3 3 3 3 3 3 ...

## $ Total.Looking.Time : num 44 18.3 24.6 12.9 12.8 ...

## $ First.Face.Looking.Time: num 8.27 6.94 4.22 7.54 4.23 ...

BabyData$Face.Race <- as.factor(BabyData$Face.Race)

BabyData$Music.Emotion <- as.factor(BabyData$Music.Emotion)

BabyData$Condition <- as.factor(BabyData$Condition)

6. Vérifiez si votre modèle est équilibré ou déséquilibré.

table(BabyData$Age.Group, BabyData$Condition) #unbalanced design

##

## Other-Race Happy Music Other-Race Sad Music Own-Race Happy Music

## 3 16 12 12

## 6 15 19 19

## 9 14 17 17

##

## Own-Race Sad Music

## 3 17

## 6 15

## 9 17

Exercice 2 : Réalisation d’une analyse de régression linéaire multi-variable

7. Effectuez une régression linéaire multi-variable sur le temps de regard du premier visage en tant que variable prédite, avec le groupe, la race du visage et leurs interactions en tant que variables prédictives. Affichez le résultat.

lm_model1 <- lm(First.Face.Looking.Time ~ Age.Group*Face.Race, data = BabyData)

summary(lm_model1)

##

## Call:

## lm(formula = First.Face.Looking.Time ~ Age.Group * Face.Race,

## data = BabyData)

##

## Residuals:

## Min 1Q Median 3Q Max

## -7.4524 -1.4478 0.3645 2.0507 4.5670

##

## Coefficients:

## Estimate Std. Error t value Pr(>|t|)

## (Intercept) 5.50710 0.75573 7.287 8.75e-12 ***

## Age.Group 0.22815 0.11542 1.977 0.0496 *

## Face.RaceChinese -0.04233 1.05722 -0.040 0.9681

## Age.Group:Face.RaceChinese 0.05036 0.16071 0.313 0.7544

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

##

## Residual standard error: 2.658 on 186 degrees of freedom

## Multiple R-squared: 0.05411, Adjusted R-squared: 0.03885

## F-statistic: 3.546 on 3 and 186 DF, p-value: 0.01564

8. Effectuez une régression linéaire multivariable similaire à celle décrite dans la question précédente. La variable prédite doit être le temps total de recherche, avec comme prédicteurs le groupe d’âge, la race du visage, l’émotion musicale et leurs interactions.

lm_model2 <- model <- lm(Total.Looking.Time ~ Age.Group * Face.Race * Music.Emotion, data = BabyData)

summary(lm_model2)

##

## Call:

## lm(formula = Total.Looking.Time ~ Age.Group * Face.Race * Music.Emotion,

## data = BabyData)

##

## Residuals:

## Min 1Q Median 3Q Max

## -24.8431 -8.0316 -0.1786 8.2809 27.7472

##

## Coefficients:

## Estimate Std. Error t value

## (Intercept) 28.0472 4.5406 6.177

## Age.Group -0.5167 0.7144 -0.723

## Face.RaceChinese -11.5424 6.6960 -1.724

## Music.Emotionsad -15.2955 6.6960 -2.284

## Age.Group:Face.RaceChinese 3.0376 1.0229 2.970

## Age.Group:Music.Emotionsad 3.4057 1.0229 3.330

## Face.RaceChinese:Music.Emotionsad 26.8342 9.3820 2.860

## Age.Group:Face.RaceChinese:Music.Emotionsad -5.7421 1.4252 -4.029

## Pr(>|t|)

## (Intercept) 4.16e-09 ***

## Age.Group 0.47045

## Face.RaceChinese 0.08645 .

## Music.Emotionsad 0.02351 *

## Age.Group:Face.RaceChinese 0.00338 **

## Age.Group:Music.Emotionsad 0.00105 **

## Face.RaceChinese:Music.Emotionsad 0.00473 **

## Age.Group:Face.RaceChinese:Music.Emotionsad 8.22e-05 ***

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

##

## Residual standard error: 11.72 on 182 degrees of freedom

## Multiple R-squared: 0.1742, Adjusted R-squared: 0.1425

## F-statistic: 5.486 on 7 and 182 DF, p-value: 9.76e-06

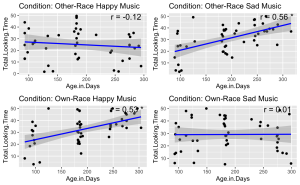

9. Compte tenu de l’interaction significative à trois voies, effectuer des analyses de corrélation de Pearson pour examiner la relation linéaire entre le temps total passé à regarder un visage et l’âge du participant en jours dans chaque condition.

- (a) Commence par identifier toutes les conditions uniques présentes dans l’ensemble de données.

- (b) Effectue une analyse de corrélation de Pearson entre le groupe d’âge et la durée totale d’observation pour chaque condition unique.

- (c) Enregistre et imprime les résultats de la corrélation, y compris les coefficients de corrélation et les valeurs p, pour chaque condition.

unique_conditions <- unique(BabyData$Condition) #Get unique conditions

correlation_results <- list() ## Initialize a list to store results

# Loop through each condition and perform Pearson correlation

for (condition in unique_conditions) {

# Subset data for the current condition

subset_data <- subset(BabyData, Condition == condition)

subset_data$Age.Group <- as.numeric(as.character(subset_data$Age.Group))

# Perform Pearson correlation

correlation_test <- cor.test(subset_data$Age.Group, subset_data$Total.Looking.Time, method = "pearson")

# Store the result

correlation_results[[condition]] <- correlation_test

}

# Print the results

correlation_results

## $`Other-Race Happy Music`

##

## Pearson's product-moment correlation

##

## data: subset_data$Age.Group and subset_data$Total.Looking.Time

## t = -0.64059, df = 43, p-value = 0.5252

## alternative hypothesis: true correlation is not equal to 0

## 95 percent confidence interval:

## -0.3799180 0.2020743

## sample estimates:

## cor

## -0.09722666

##

##

## $`Other-Race Sad Music`

##

## Pearson's product-moment correlation

##

## data: subset_data$Age.Group and subset_data$Total.Looking.Time

## t = 4.4535, df = 46, p-value = 5.356e-05

## alternative hypothesis: true correlation is not equal to 0

## 95 percent confidence interval:

## 0.3136678 0.7206311

## sample estimates:

## cor

## 0.5488839

##

##

## $`Own-Race Happy Music`

##

## Pearson's product-moment correlation

##

## data: subset_data$Age.Group and subset_data$Total.Looking.Time

## t = 3.8943, df = 46, p-value = 0.0003166

## alternative hypothesis: true correlation is not equal to 0

## 95 percent confidence interval:

## 0.2490419 0.6851408

## sample estimates:

## cor

## 0.4979416

##

##

## $`Own-Race Sad Music`

##

## Pearson's product-moment correlation

##

## data: subset_data$Age.Group and subset_data$Total.Looking.Time

## t = 0.25438, df = 47, p-value = 0.8003

## alternative hypothesis: true correlation is not equal to 0

## 95 percent confidence interval:

## -0.2466891 0.3149919

## sample estimates:

## cor

## 0.03707966

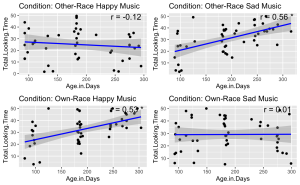

Exercice 3 : Visualisation des données

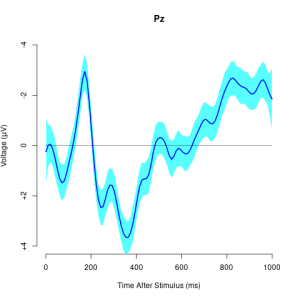

10. Visualisez la relation entre le temps total passé à regarder un visage et l’âge du participant en jours, en fonction des différentes conditions expérimentales. Chaque condition doit être représentée dans son propre panneau à l’intérieur d’une seule figure. En outre, pour chaque panneau :

- (a) Tracez le temps total passé par chaque enfant à regarder le visage en fonction de son âge en jours.

- (b) Ajoutez une ligne de régression linéaire bleue pour indiquer la tendance.

- (c) Affichez le coefficient de corrélation de Pearson que vous avez calculé à la question précédente dans le coin supérieur droit de chaque panneau. Pour l’affichage, arrondissez vos calculs à deux décimales.

- (d) Utilisez des panneaux différents pour chaque condition expérimentale et disposez-les en grille.

- (e) Veillez à ce qu’une corrélation significative (p < 0,05) soit indiquée par un astérisque.

# Get unique conditions

conditions <- unique(BabyData$Condition)

# Create a list to store plots

plot_list <- list()

# Loop through each condition and create a plot

for (condition in conditions) {

# Subset data for the condition

subset_data <- subset(BabyData, Condition == condition)

# Perform linear regression

fit <- lm(Total.Looking.Time ~ Age.in.Days, data = subset_data)

# Calculate Pearson correlation

cor_test <- cor.test(subset_data$Age.in.Days, subset_data$Total.Looking.Time)

# Create a scatter plot with regression line

p <- ggplot(subset_data, aes(x = Age.in.Days, y = Total.Looking.Time)) +

geom_point() +

geom_smooth(method = 'lm', color = 'blue') +

ggtitle(paste('Condition:', condition)) +

annotate("text", x = Inf, y = Inf, label = paste('r =', round(cor_test$estimate, 2), ifelse(cor_test$p.value < 0.05, "*", "")),

hjust = 1.1, vjust = 1.1, size = 5)

# Add plot to list

plot_list[[condition]] <- p

}

do.call(grid.arrange, c(plot_list, ncol = 2))

Exercice 4 : réalisation de tests T sur des échantillons indépendants

11. Analysez l’impact de la valence émotionnelle de la musique sur le temps de regard des visages de sa propre race et d’autres races dans différents groupes d’âge de nourrissons (3, 6 et 9 mois). Plus précisément, vous devez effectuer une série de tests t sur des échantillons indépendants.

- (a) En utilisant la colonne Age.Group, effectuez des tests t d’échantillons indépendants pour examiner les effets de la valence émotionnelle de la musique (Music. Emotion) sur le temps de regard (Total.Looking.Time) pour les visages de sa propre race et d’autres races (Face.Race) dans chaque groupe d’âge.

- (b) Assurez-vous que votre script tient compte des différentes combinaisons de groupes d’âge et de valences émotionnelles de la musique.

- (c) Stockez et affichez les résultats de ces tests t de manière organisée.

# Ensure Age.Group is treated as a factor

BabyData$Age.Group <- as.factor(BabyData$Age.Group)

# Perform t-tests for each combination of Age.Group, Music.Emotion, and Face.Race

results <- list()

for(age_group in levels(BabyData$Age.Group)) {

for(music_emotion in unique(BabyData$Music.Emotion)) {

# Filter data for specific age group and music emotion

subset_data <- BabyData %>%

filter(Age.Group == age_group, Music.Emotion == music_emotion)

# Perform the t-test comparing Total.Looking.Time for own- vs. other-race faces

t_test_result <- t.test(Total.Looking.Time ~ Face.Race, data = subset_data)

# Store the results

result_name <- paste(age_group, music_emotion, sep="_")

results[[result_name]] <- t_test_result

}

}

# Print results

print(results)

## $`3_happy`

##

## Welch Two Sample t-test

##

## data: Total.Looking.Time by Face.Race

## t = -0.3153, df = 22.294, p-value = 0.7555

## alternative hypothesis: true difference in means between group African and group Chinese is not equal to 0

## 95 percent confidence interval:

## -12.465591 9.173257

## sample estimates:

## mean in group African mean in group Chinese

## 22.76875 24.41492

##

##

## $`3_sad`

##

## Welch Two Sample t-test

##

## data: Total.Looking.Time by Face.Race

## t = -1.0492, df = 22.86, p-value = 0.3051

## alternative hypothesis: true difference in means between group African and group Chinese is not equal to 0

## 95 percent confidence interval:

## -17.297369 5.658457

## sample estimates:

## mean in group African mean in group Chinese

## 21.32725 27.14671

##

##

## $`6_happy`

##

## Welch Two Sample t-test

##

## data: Total.Looking.Time by Face.Race

## t = 0.43226, df = 27.324, p-value = 0.6689

## alternative hypothesis: true difference in means between group African and group Chinese is not equal to 0

## 95 percent confidence interval:

## -6.401791 9.821475

## sample estimates:

## mean in group African mean in group Chinese

## 32.90100 31.19116

##

##

## $`6_sad`

##

## Welch Two Sample t-test

##

## data: Total.Looking.Time by Face.Race

## t = -0.62019, df = 27.075, p-value = 0.5403

## alternative hypothesis: true difference in means between group African and group Chinese is not equal to 0

## 95 percent confidence interval:

## -9.635393 5.162123

## sample estimates:

## mean in group African mean in group Chinese

## 30.20163 32.43827

##

##

## $`9_happy`

##

## Welch Two Sample t-test

##

## data: Total.Looking.Time by Face.Race

## t = -6.0414, df = 21.29, p-value = 5.08e-06

## alternative hypothesis: true difference in means between group African and group Chinese is not equal to 0

## 95 percent confidence interval:

## -27.28467 -13.31931

## sample estimates:

## mean in group African mean in group Chinese

## 19.13607 39.43806

##

##

## $`9_sad`

##

## Welch Two Sample t-test

##

## data: Total.Looking.Time by Face.Race

## t = 3.0179, df = 26.642, p-value = 0.005546

## alternative hypothesis: true difference in means between group African and group Chinese is not equal to 0

## 95 percent confidence interval:

## 3.335708 17.533234

## sample estimates:

## mean in group African mean in group Chinese

## 38.68853 28.25406

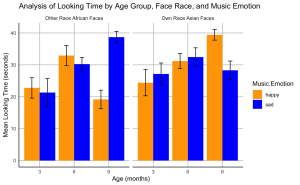

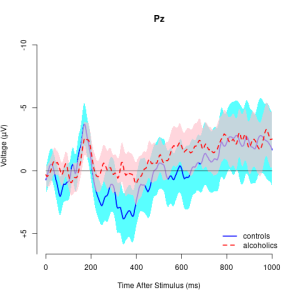

Exercice 5 Création d’un diagramme à barres

12. Créez un diagramme à barres pour visualiser les effets de la valence émotionnelle de la musique sur le temps de regard des nourrissons à différents âges pour les visages de leur propre race et ceux d’une autre race.

- (a) Le graphique doit montrer le temps total moyen passé à regarder les visages de sa propre race et ceux d’une autre race associés à une musique joyeuse ou triste pour chaque groupe d’âge.

- (b) Incluez les barres d’erreur standard dans votre graphique.

- (c) Organisez les barres de manière à ce que les barres représentant les visages de votre propre race soient regroupées et étiquetées “Visages asiatiques de votre propre race”, suivies des barres représentant les visages d’autres races regroupées et étiquetées “Visages africains d’autres races”.

- (d) La couleur des barres doit représenter l’émotion musicale : utilisez le bleu pour la musique triste et l’orange pour la musique joyeuse.

- (e) Inscrivez sur l’axe des x “Âge (mois)” et sur l’axe des y “Temps de regard moyen (secondes)”.

- (f) Intitulez votre graphique “Analyse du temps de regard par tranche d’âge, par race de visage et par émotion musicale”

- (g) Définissez le thème de votre graphique comme étant minimal. Assurez-vous que les lignes des axes x et y sont des lignes noires pleines.

- (h) Votre graphique ne doit pas afficher de lignes de grille mineures, mais uniquement des lignes de grille majeures.

# Calculate means and standard errors

data_summary <- BabyData %>%

group_by(Age.Group, Face.Race, Music.Emotion) %>%

summarize(Mean = mean(Total.Looking.Time),

SE = sd(Total.Looking.Time)/sqrt(n())) %>%

ungroup()

## `summarise()` has grouped output by 'Age.Group', 'Face.Race'. You can override

## using the `.groups` argument.

# Create the bar plot

ggplot(data_summary, aes(x = factor(Age.Group), y = Mean, fill = Music.Emotion)) +

geom_bar(stat = "identity", position = position_dodge()) +

geom_errorbar(aes(ymin = Mean - SE, ymax = Mean + SE),

position = position_dodge(0.9), width = 0.25) +

scale_fill_manual(values = c("happy" = "orange", "sad" = "blue")) +

facet_wrap(~ Face.Race, scales = "free_x", labeller = labeller(Face.Race = c(Chinese = "Own Race Asian Faces", African = "Other Race African Faces"))) +

labs(x = "Age (months)", y = "Mean Looking Time (seconds)", title = "Analysis of Looking Time by Age Group, Face Race, and Music Emotion") +

theme_minimal() +

theme(

panel.grid.minor = element_blank(),

panel.grid.major = element_line(color = "gray", size = 0.5, linetype = "solid"), # Major grid lines

axis.line = element_line(color = "black", size = 0.5) # Axis lines

)

P04: Laboratoire de perception et de sensorimotricité

Sevda Montakhaby Nodeh

Laboratoire de perception et de sensorimotricité

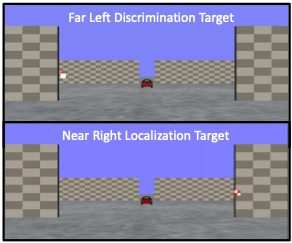

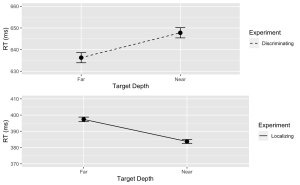

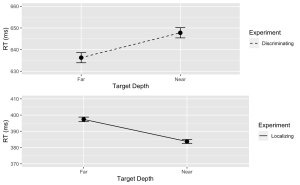

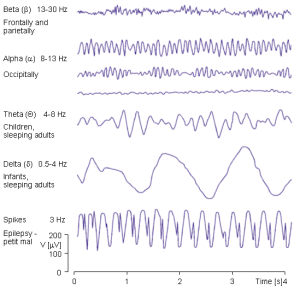

Bienvenue au laboratoire de perception et de sensorimotricité de l’université McMaster. En tant que psychologue cognitif en herbe, vous êtes sur le point d’entreprendre un voyage exploratoire sur l’effet de profondeur, un phénomène psychologique captivant qui suggère que les événements visuels se produisant à proximité (espace proche) sont traités plus efficacement que ceux qui sont plus éloignés (espace lointain). Cet effet offre une fenêtre unique sur l’architecture cognitive qui sous-tend nos expériences sensorielles, impliquant probablement l’implication du flux visuel dorsal, qui traite les relations spatiales et les mouvements dans l’espace proche, et le flux ventral, connu pour son rôle dans la reconnaissance d’informations visuelles détaillées.

Votre objectif est de déterminer si l’effet de profondeur est dépendant de la tâche, s’alignant strictement sur la dichotomie flux dorsal/flux ventral, ou s’il représente un avantage de traitement universel pour les stimuli dans l’espace proche à travers diverses tâches cognitives.

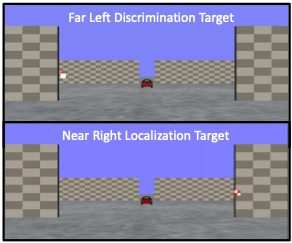

Votre parcours de recherche commence dans votre laboratoire. Imaginez le laboratoire comme une passerelle vers un monde tridimensionnel, où le concept de profondeur n’est pas seulement un sujet d’étude, mais aussi une expérience sensorielle vécue par vos participants ! Assis à l’intérieur d’une tente sombre, chaque participant tient un volant, son principal outil d’interaction et de saisie de réponses. Devant eux, un écran prend vie avec un environnement virtuel en 3D méticuleusement conçu pour tester les limites de la perception de la profondeur.

Le paysage virtuel auquel les participants sont confrontés est un modèle de simplicité et de complexité ; comme l’illustre la figure ci-dessous, devant les participants, un plan au sol s’étend dans la profondeur de l’écran, entrecoupé par deux séries de murs verticaux à des profondeurs variables – proches et éloignés. Les murs se trouvent de part et d’autre de l’axe central et se reflètent parfaitement sur la ligne médiane. Les textures du sol et des espaces réservés – une matrice de points aléatoires et un motif en damier, respectivement – conservent une densité constante. Ces indices visuels, ainsi que les gradients texturaux et la différence de taille rétinienne entre les objets proches et éloignés, agissent comme des repères subtils pour la perception de la profondeur.

De leur point de vue à la première personne, les participants sont invités à :

- Soit discriminer l’orientation d’une cible triangulaire rouge, soit localiser un carré à carreaux dans un environnement immersif en 3D.

- Les cibles peuvent apparaître dans des espaces proches ou éloignés, ce qui exige une discrimination et une localisation sensorielles poussées.

Grâce à cette expérience, vous ne vous contentez pas d’observer l’effet de profondeur ; vous le disséquerez, en découvrant les processus cognitifs qui permettent aux humains de naviguer dans la danse complexe de la profondeur dans notre vie quotidienne !

Commençons par charger les bibliothèques requises et le jeu de données. Pour ce faire, téléchargez le fichier “NearFarRep_Outlier.csv” et exécutez le code suivant.

Remarque : les cases grisées contiennent le code R, le signe “#” indiquant un commentaire qui ne s’exécutera pas dans RStudio.

# Loading the required

libraries library(tidyverse) # for data manipulation

library(rstatix) # for statistical analyses

library(emmeans) # for pairwise comparisons

library(afex) # for running anova using aov_ez and aov_car

library(kableExtra) # formatting html ANOVA tables

library(ggpubr) # for making plots

library(grid) # for plots

library(gridExtra) # for arranging multiple ggplots for extraction

library(lsmeans) # for pairwise comparisons

Lisez l’ensemble de données téléchargé “NearFarRep_Outlier.csv” en tant que “NearFarData”. N’oubliez pas de remplacer “path_to_your_downloaded_file” par le chemin réel de l’ensemble de données sur votre système.

NearFarData <- read.csv('path_to_your_downloaded_file/NearFarRep_Outlier.csv')

L’ensemble de données contient les temps de réponse des participants et comprend les colonnes suivantes :

- “Response” indique le type de tâche (discrimination ou localisation)

- “Con” indique la profondeur de la cible (proche ou lointaine)

- “TarRT” représente les temps de réponse de la cible.

Fichiers à télécharger :

- NearFarRep_Outlier.csv

Veuillez compléter les exercices ci-joints au mieux de vos capacités.

An interactive H5P element has been excluded from this version of the text. You can view it online here:

https://ecampusontario.pressbooks.pub/rspnc/?p=156#h5p-4

Solutions

Exercice 1 : préparer et explorer les données

Remarque : les cases grisées contiennent le code R, tandis que les cases blanches affichent la sortie du code, telle qu’elle apparaît dans RStudio.

Le signe “#” indique un commentaire qui ne sera pas exécuté dans RStudio.

1. Affichez les premières lignes pour comprendre votre ensemble de données. Affichez tous les noms de colonnes de l’ensemble de données.

head(NearFarData) #Displaying the first few rows

## X ID Response Con TarRT

## 1 1 10 Loc Near 0.6200754

## 2 2 10 Loc Near 0.2219719

## 3 3 1 Loc Near 0.2270377

## 4 4 9 Loc Near 0.5270686

## 5 5 25 Loc Near 0.2272455

## 6 6 18 Loc Near 0.2292785

## [1] "X" "ID" "Response" "Con" "TarRT"

2. Définissez “Response” et “Con” comme facteurs, puis vérifiez la structure de vos données pour vous assurer que vos facteurs et niveaux sont correctement définis.

NearFarData <- NearFarData %>%

convert_as_factor(Response, Con)

str(NearFarData)

## 'data.frame': 11154 obs. of 5 variables:

## $ X : int 1 2 3 4 5 6 7 8 9 10 ...

## $ ID : int 10 10 1 9 25 18 4 9 8 18 ...

## $ Response: Factor w/ 2 levels "Disc","Loc": 2 2 2 2 2 2 2 2 2 2 ...

## $ Con : Factor w/ 2 levels "Far","Near": 2 2 2 2 2 2 2 2 2 2 ...

## $ TarRT : num 0.62 0.222 0.227 0.527 0.227 ...

3. Effectuer des contrôles de base des données pour vérifier les valeurs manquantes et la cohérence des données.

sum(is.na(NearFarData)) # Checking for missing values in the dataset

4. Convertissez les valeurs de votre colonne de mesures dépendantes “TarRT” en secondes.

NearFarData$TarRT <- NearFarData$TarRT * 1000

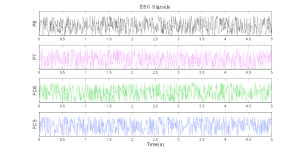

Exercice 2 : Visualiser les données

- En utilisant le paquetage “dplyr”, écrivez un code R pour calculer le temps de réponse moyen et l’erreur standard de la moyenne (SERT) pour chaque combinaison de vos deux facteurs (Response et Con).

# Calculate means and standard errors for each combination of 'Response' and 'Con'

summary_df <- NearFarData %>%

group_by(Response, Con) %>%

summarise(

MeanRT = mean(TarRT),

SERT = sd(TarRT) / sqrt(n())

)

6. En utilisant le package “ggplot2”, créez un graphique linéaire avec des barres d’erreur pour la tâche de discrimination.

- (a) L’axe des x doit représenter la profondeur de la cible (Con) et être étiqueté “Profondeur de la cible”.

- (b) L’axe des y doit représenter le temps de réponse moyen (MeanRT) et être étiqueté “RT (ms)”

- (c) Les barres d’erreur doivent représenter l’erreur standard de la moyenne (SERT).

- (d) Assurez-vous que le type de ligne est solide.

- (e) Fixez la valeur minimale de l’axe des y à 630 et la valeur maximale à 660.

# Now, using ggplot to create the plot

Disc.plot <- ggplot(data = filter(summary_df, Response=="Disc"), aes(x = Con, y = MeanRT, group = Response)) +

geom_line(aes(linetype = "Discriminating")) + # Add a linetype aesthetic

geom_errorbar(aes(ymin = MeanRT - SERT, ymax = MeanRT + SERT), width = 0.1) +

geom_point(size = 3) +

theme_gray() +

labs(